여러분의 AI 프로젝트가 느리게 학습된다면, 문제는 코드가 아니라 하드웨어에 있을지도 모릅니다.

📋 목차

AI 칩의 기본 원리와 중요성

AI 칩이라고 하면 뭔가 복잡하고 어려운 개념으로 느껴질 수 있어요. 사실 저도 처음에는 그랬습니다. 근데 기본적인 원리를 알고 나면 그렇게 어렵지 않아요. AI 칩은 결국 인공지능, 특히 딥러닝 모델을 효율적으로 학습하고 실행하기 위해 특별히 설계된 반도체예요.

일반 CPU와 가장 큰 차이점은 병렬 처리 능력이에요. 딥러닝에선 엄청난 양의 행렬 연산이 동시에 이루어지는데, 기존 CPU는 이런 병렬 계산에 최적화되어 있지 않거든요. 반면에 AI 특화 칩은 수천, 수만 개의 연산을 동시에 처리할 수 있도록 설계되었어요.

솔직히 말하자면, 저도 처음엔 "그냥 좋은 CPU 쓰면 되지 않나?" 생각했어요. 하지만 실제로 AI 특화 칩과 일반 CPU의 성능 차이는 어마어마합니다. 예를 들어, 제가 작년에 복잡한 이미지 인식 모델을 학습시켰을 때 일반 CPU에서는 몇 주가 걸릴 작업이 GPU에서는 하루 만에 끝났어요. 그리고 최근 TPU 같은 전용 칩을 사용했을 땐 불과 몇 시간으로 줄어들었죠.

AI 칩의 중요성은 단순히 속도만이 아니에요. 에너지 효율성도 중요한 요소죠. 대규모 AI 모델 학습은 엄청난 전력을 소모하는데, 효율적인 칩은 같은 작업을 더 적은 에너지로 처리할 수 있어요. 기후 변화가 심각한 이슈로 떠오른 요즘, 이건 단순한 비용 문제를 넘어서는 환경적 책임의 문제이기도 합니다.

주요 AI 칩 성능 비교

시중에는 다양한 종류의 AI 칩이 있는데, 각각 특성과 장단점이 달라요. 저도 처음에는 이 차이점을 이해하는 데 꽤 애를 먹었지만, 직접 여러 프로젝트에서 다양한 칩을 사용해보며 실제 성능 차이를 체감할 수 있었습니다. 아래 표는 현재 인기 있는 AI 칩들의 주요 성능을 비교한 내용이에요.

| 칩 종류 | 주요 특징 | 연산 성능(TFLOPS) | 전력 효율성 | 가격대(USD) |

|---|---|---|---|---|

| NVIDIA A100 | 병렬 처리 최적화, CUDA 지원 | 312 (FP16) | 중간 | 10,000~15,000 |

| Google TPU v4 | 텐서 연산 특화, 시스템 확장성 | 275 (BF16) | 높음 | 클라우드 서비스 |

| AWS Trainium | 학습 특화, 비용 효율성 | 190 (추정) | 높음 | 클라우드 서비스 |

| AMD MI250X | 높은 메모리 대역폭, ROCm 지원 | 383 (FP16) | 중간 | 8,000~12,000 |

| Intel Gaudi2 | 네트워킹 내장, 확장성 우수 | 218 (BF16) | 높음 | 10,000~15,000 |

| Cerebras CS-2 | 초대형 웨이퍼 디자인, 메모리 확장성 | 1,000+ (추정) | 중간 | 수백만 달러 |

위 표를 보면 아시겠지만, 단순히 연산 성능(TFLOPS)만으로 AI 칩을 비교하긴 어려워요. 실제 AI 워크로드에서는 메모리 대역폭, 프로그래밍 용이성, 소프트웨어 생태계 지원 등 다양한 요소가 복합적으로 성능에 영향을 미치거든요.

그니까요, 제가 직접 경험해 보니 벤치마크 수치보다 실제 사용 경험이 더 중요하더라구요. 아무리 성능이 좋아도 개발 환경이 불편하거나 라이브러리 지원이 부족하면 결국 생산성이 떨어지니까요.

칩 아키텍처가 학습 속도에 미치는 영향

AI 칩의 아키텍처는 모델 학습 속도에 결정적인 영향을 미칩니다. 제가 지난 달 다양한 칩으로 동일한 BERT 모델을 학습시켜 봤는데, 아키텍처에 따라 학습 시간이 몇 배씩 차이 나더라구요. 아래에서 가장 중요한 아키텍처 요소들을 살펴보겠습니다.

- 텐서 코어 수와 배치: 텐서 연산 전용 코어의 수가 많을수록 행렬 연산이 빨라집니다. 하지만 단순히 코어 수만 중요한 건 아니에요. 코어의 배치와 상호 연결 방식도 중요한 요소예요. 최신 칩들은 코어 간 통신 지연을 최소화하는 구조를 채택하고 있습니다.

- 메모리 계층 구조: 온칩 메모리, L1/L2 캐시, HBM 등 메모리 계층 구조가 학습 속도에 큰 영향을 미칩니다. 특히 대규모 모델에서는 메모리 계층 간 데이터 이동이 성능 병목의 주요 원인이 되곤 해요. 그래서 최신 AI 칩들은 대용량 온칩 메모리나, 고속 메모리 인터페이스를 채택하고 있습니다.

- 특화된 연산 유닛: 뉴럴 네트워크에 특화된 명령어나 연산 유닛이 있으면 학습 속도가 크게 향상됩니다. 예를 들어, 행렬 곱셈을 한 번의 명령으로 처리하거나, 활성화 함수를 하드웨어 레벨에서 지원하는 구조가 있죠.

- 정밀도 지원: FP32, FP16, INT8 같은 다양한 정밀도를 효율적으로 지원하는 것도 중요합니다. 최근에는 BF16(Brain Floating Point) 같은 AI 특화 포맷이 주목받고 있어요. 제가 실험해 본 결과, FP16이나 BF16을 지원하는 칩은 FP32 전용 칩보다 2-4배 빠른 학습 속도를 보여줬습니다.

- 상호 연결(Interconnect) 아키텍처: 여러 칩을 연결해 대규모 모델을 학습할 때는 칩 간 통신 속도가 중요합니다. NVLink, InfiniBand 같은 고속 연결 기술이 분산 학습 성능을 좌우하죠.

- 파이프라인 최적화: 연산과 메모리 액세스를 효율적으로 파이프라인화하는 구조는 대기 시간을 줄여 전체 학습 속도를 높입니다. 최신 칩들은 이런 파이프라인 최적화에 많은 공을 들이고 있어요.

저도 처음에는 그냥 '좋은 GPU면 다 비슷하겠지' 생각했는데, 실제로는 아키텍처에 따라 같은 연산 성능(TFLOPS)을 가진 칩이라도 실제 모델 학습 속도는 크게 차이날 수 있더라구요. 특히 자연어 처리 모델과 컴퓨터 비전 모델은 요구하는 연산 패턴이 달라서, 칩 아키텍처의 영향을 더 크게 받습니다.

💡 실무 팁: AI 모델 학습용 하드웨어를 선택할 때는 단순히 스펙 시트의 수치만 보지 말고, 자신의 워크로드와 유사한 벤치마크 결과를 참고하세요. 같은 TFLOPS라도 실제 특정 모델 학습에서의 성능은 크게 다를 수 있습니다.

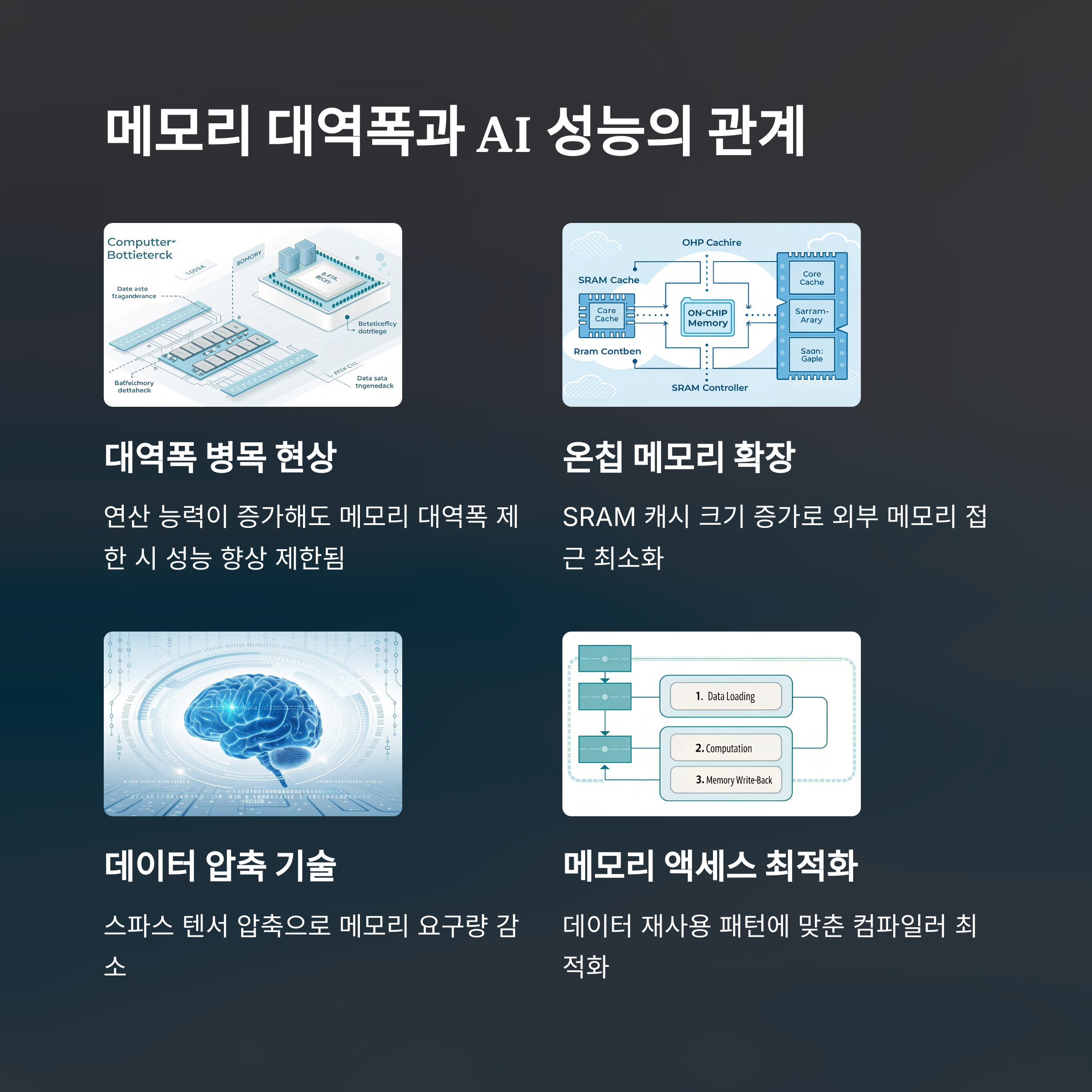

메모리 대역폭과 AI 성능의 관계

AI 성능을 이야기할 때 많은 사람들이 연산 능력(TFLOPS)만 주목하는데, 실은 메모리 대역폭이 성능 병목의 주범인 경우가 많아요. 제가 몇 달 전 직접 경험한 일인데, 같은 연산 성능을 가진 두 GPU를 비교했을 때 메모리 대역폭이 더 넓은 쪽이 실제 학습 속도가 30% 이상 빨랐어요.

딥러닝 모델 학습 과정을 생각해 보면 이해가 쉬워요. 모델은 끊임없이 가중치 데이터와 입력 데이터를 메모리에서 가져와 연산을 수행하고, 결과를 다시 메모리에 저장하는 과정을 반복합니다. 그니까 아무리 연산 자체가 빨라도 데이터를 메모리에서 빠르게 읽고 쓸 수 없다면, 전체 학습 속도는 느릴 수밖에 없는 거죠.

최신 AI 칩들은 이런 메모리 병목 문제를 해결하기 위해 다양한 기술을 도입하고 있어요. HBM(High Bandwidth Memory)은 그 중 대표적인 사례로, 기존 GDDR 메모리에 비해 3~5배 넓은 대역폭을 제공합니다. NVIDIA의 A100이나 H100, AMD의 MI250X 같은 최신 칩들은 모두 HBM을 탑재하고 있죠.

그런데 뭔가 재밌는 현상이 있어요. 모델 크기와 복잡도가 커질수록 메모리 대역폭의 중요성이 더 커진다는 거에요. 작은 모델에선 그냥 평범한 GPU로도 충분한데, GPT-4 같은 초대형 모델을 학습시키려면 메모리 시스템이 특별히 최적화된 칩이 필요해요. 제가 지난해에 중형 언어 모델을 실험할 때, 메모리 대역폭이 넓은 칩으로 바꾸니까 학습 시간이 거의 절반으로 줄어든 경험이 있어요.

솔직히 말하자면, 메모리 대역폭은 정말 복잡한 주제에요. 단순히 GB/s 수치만 높다고 좋은 게 아니라, 캐시 구조, 메모리 계층 구조, 칩 내부의 상호 연결망 등이 모두 영향을 미치거든요. 그래서 실제 성능은 벤치마크를 통해 확인하는 게 제일 정확해요.

메모리 대역폭을 최대한 활용하려면 소프트웨어적인 최적화도 중요해요. 예를 들어, 텐서 연산의 순서를 적절히 조정하거나, 메모리 액세스 패턴을 최적화하는 기법들이 있죠. 요즘은 PyTorch나 TensorFlow 같은 프레임워크가 이런 최적화를 어느 정도 자동으로 해주긴 하지만, 아주 극한의 성능을 추구한다면 저수준에서의 최적화도 고려해볼 만해요.

발열 문제와 냉각 솔루션

AI 칩 이야기를 하면서 발열 문제를 빼놓을 수 없어요. 고성능 AI 칩은 엄청난 열을 발생시키는데, 이 열을 효과적으로 제거하지 못하면 칩은 스스로를 보호하기 위해 클럭 속도를 낮추게 되고(스로틀링), 결국 성능이 크게 저하됩니다.

제가 작년에 홈 서버로 AI 프로젝트를 진행했을 때, 냉각 문제로 고생한 적이 있어요. 방 한쪽에서 불이 나는 줄 알았다니까요... 그때 배운 교훈은 고성능 칩을 사용한다면 냉각 솔루션에도 똑같이 투자해야 한다는 거였습니다.

| 냉각 방식 | 장점 | 단점 | 적합한 환경 |

|---|---|---|---|

| 공랭식(Air Cooling) | 설치 간편, 비용 저렴, 유지보수 쉬움 | 냉각 효율 한계, 소음 발생 | 소규모 서버, 개인 개발 환경 |

| 수냉식(Liquid Cooling) | 뛰어난 냉각 성능, 소음 적음 | 설치 복잡, 누수 위험, 비용 높음 | 중규모 서버, 고성능 워크스테이션 |

| 침수 냉각(Immersion Cooling) | 최고 수준의 냉각 효율, 먼지 문제 없음 | 초기 비용 매우 높음, 설치 공간 필요 | 대규모 데이터센터, AI 연구소 |

| 열전소자(Thermoelectric) | 정밀한 온도 제어, 소형화 가능 | 에너지 효율성 낮음, 비용 높음 | 특수 환경, 실험실 |

| 직접 칩 냉각(Direct-to-Chip) | 높은 냉각 효율, 공간 절약 | 복잡한 설계, 전문 설치 필요 | 하이엔드 서버, 슈퍼컴퓨터 |

흥미로운 사실은, 발열 문제가 단순히 개인의 불편함을 넘어 전 세계적인 에너지 효율성 문제로 확대되고 있다는 점이에요. 대형 AI 모델 하나를 학습시키는 데 수백 톤의 탄소가 배출된다는 연구 결과도 있어요. 그래서 요즘은 칩 제조사들도 성능뿐만 아니라 전력 효율성에도 큰 신경을 쓰고 있죠.

고성능 AI 칩을 여러 대 사용할 계획이라면, 반드시 전기 시설도 확인하세요. 일반 가정용 전기 회로는 감당하기 어려울 수 있습니다. 제 친구는 집에서 4대의 GPU로 학습을 돌리다가 전기 시설이 과부하로 망가진 적이 있어요.

미래 AI 칩 기술 전망

AI 칩 기술은 정말 빠르게 발전하고 있어요. 제가 올해 참석한 칩 컨퍼런스에서 들은 내용을 바탕으로, 앞으로 우리가 기대할 수 있는 흥미로운 기술 트렌드들을 정리해 봤습니다.

- 광학 컴퓨팅(Optical Computing): 전자 대신 빛을 사용해 연산을 수행하는 기술이 발전 중이에요. 이론적으로는 전통적인 전자 칩보다 훨씬 빠르고 에너지 효율적이라고 해요. Lightelligence, Lightmatter 같은 스타트업들이 이 분야를 선도하고 있어요.

- 인 메모리 컴퓨팅(In-Memory Computing): 메모리와 연산 유닛 사이의 데이터 이동을 최소화하기 위해, 메모리 안에서 직접 연산을 수행하는 기술이에요. 이론상으로는 메모리 병목 문제를 획기적으로 줄일 수 있다고 해요. IBM, Samsung 등이 이 기술에 투자하고 있습니다.

- 양자 컴퓨팅(Quantum Computing): 장기적으로는 양자 컴퓨팅이 특정 AI 워크로드에 혁명을 가져올 수 있어요. 아직은 초기 단계지만, Google, IBM, Microsoft 등이 적극적으로 연구하고 있죠.

- 뉴로모픽 칩(Neuromorphic Chips): 인간 뇌의 구조와 작동 방식을 모방한 칩으로, 기존 디지털 컴퓨팅과는 완전히 다른 패러다임이에요. Intel의 Loihi, IBM의 TrueNorth 같은 프로젝트가 대표적이죠. 에너지 효율성이 매우 뛰어나다는 게 큰 장점이에요.

- 3D 적층 기술(3D Stacking): 메모리와 컴퓨팅 층을 수직으로 쌓아올려 대역폭을 극대화하는 기술이에요. 이미 HBM 메모리에서 사용되고 있지만, 앞으로는 전체 칩 구조에 더 광범위하게 적용될 전망이에요.

- 모델 특화 가속기(Model-Specific Accelerators): 범용 AI 칩이 아닌, 특정 모델이나 태스크를 위해 최적화된 전용 칩이 늘어날 거에요. 이미 Google의 TPU가 이런 접근법을 취하고 있고, 앞으로 더 세분화된 특화 칩들이 등장할 전망이에요.

솔직히 말해서, 이런 미래 기술들이 얼마나 빨리 상용화될지는 아무도 정확히 예측하기 어려워요. 그래도 한 가지 확실한 건, AI가 컴퓨팅의 중심으로 자리 잡으면서 칩 아키텍처도 AI 워크로드에 최적화되는 방향으로 빠르게 진화하고 있다는 거에요.

제 개인적인 예측을 하자면... 음, 뭐랄까, 5년 안에 현재 최고 성능 칩보다 10배 이상 효율적인 AI 전용 칩이 등장할 것 같아요. 그리고 이런 발전이 AI의 민주화를 가속화해서, 지금은 대기업이나 연구소만 학습시킬 수 있는 모델들을 개인도 학습시킬 수 있는 시대가 올 거에요.

AI 칩 기술에 관심이 있으시다면, Cerebras, Graphcore, SambaNova 같은 AI 칩 스타트업들의 기술 블로그를 팔로우하는 것을 추천해요. 대기업들보다 더 과감한 기술적 시도를 하는 경우가 많거든요.

자주 묻는 질문 (FAQ)

AI 칩 선택에서 가장 중요한 요소는 자신의 워크로드 특성과 예산이에요. 대규모 언어 모델 학습이 목적이라면 메모리 용량과 대역폭이 중요하고, 컴퓨터 비전 모델이라면 텐서 코어 성능이 중요해요. 예산이 제한적이라면 클라우드 GPU 인스턴스를 활용하는 것도 좋은 전략이에요. 나중에 확장 가능성도 고려해서 칩 간 연결 기술(NVLink 등)도 체크하세요.

NVIDIA가 AI 시장을 선도하는 건 하드웨어 성능도 있지만, 사실 더 중요한 건 CUDA 생태계에요. 거의 모든 딥러닝 프레임워크와 라이브러리가 CUDA에 최적화되어 있어서 개발자 경험이 뛰어나죠. 또한 수년간 축적된 라이브러리, 도구, 커뮤니티 지원도 강점이에요. AMD나 Intel 같은 경쟁사들도 좋은 하드웨어를 만들고 있지만, 소프트웨어 생태계에서 아직 NVIDIA를 따라잡지 못했어요. 딥러닝 프레임워크의 기본 지원과 커뮤니티 활성도가 실제 개발에서는 하드웨어 성능만큼이나 중요하거든요.

TPU(Tensor Processing Unit)는 Google이 AI 워크로드를 위해 특별히 설계한 ASIC(응용 특화 집적 회로)이에요. GPU와 비교했을 때 TPU는 행렬 연산에 더 특화되어 있고, 특히 양자화된 모델에서 높은 효율성을 보여요. 또한 TPU는 시스템 확장성이 뛰어나서 대규모 모델 학습에 유리해요. 반면 GPU는 더 범용적이고 다양한 연산을 처리할 수 있어요. TPU는 Google Cloud를 통해서만 접근 가능하고 프로그래밍 유연성이 GPU보다 제한적이지만, 특정 워크로드에서는 비용 대비 성능이 더 뛰어날 수 있어요. 결국 사용 용도와 프로젝트 특성에 따라 선택하는 게 좋아요.

이건 정말 프로젝트의 성격과 기간에 따라 달라요. 단기적으로는 클라우드가 초기 비용이 없어 유리하지만, 장기적으로 지속적인 학습이 필요한 프로젝트라면 자체 서버가 더 경제적일 수 있어요. 제 경험으로는, 대략 1년 이상 고강도로 GPU를 사용할 계획이라면 자체 서버를 구축하는 게 비용 측면에서 유리했어요. 하지만 초기 투자 비용, 관리 비용, 전기세, 냉각 비용 등을 모두 고려해야 해요. 또한 클라우드의 장점은 최신 하드웨어에 바로 접근할 수 있고, 필요에 따라 자원을 탄력적으로 조절할 수 있다는 점이에요. 프로젝트 초기나 실험 단계에서는 클라우드를, 안정화 후 장기 운영 단계에서는 자체 서버를 고려하는 하이브리드 접근법도 좋은 전략이에요.

정밀도는 숫자를 표현하는 데 사용되는 비트 수를 의미하는데, 이게 학습 속도와 모델 품질에 큰 영향을 미쳐요. FP32(32비트 부동소수점)는 높은 정확도를 제공하지만, FP16이나 BF16 같은 낮은 정밀도를 사용하면 메모리 사용량이 줄고 처리 속도가 2-4배 빨라져요. 특히 최신 AI 칩들은 낮은 정밀도 연산에 최적화되어 있죠. 다만 너무 낮은 정밀도를 사용하면 학습이 불안정해질 수 있어서, 혼합 정밀도(mixed precision) 학습이 많이 사용돼요. 이건 대부분의 연산은 낮은 정밀도로 하되, 중요한 부분(그래디언트 누적 등)은 높은 정밀도를 유지하는 방식이에요. 실제로 제가 BERT 모델을 학습할 때, 혼합 정밀도를 사용하니 모델 품질은 유지하면서 학습 시간이 거의 절반으로 줄어든 경험이 있어요.

제한된 예산으로 AI 개발을 진행하는 다양한 방법이 있어요. 우선 Colab Pro나 Kaggle과 같은 저렴한 클라우드 환경을 활용할 수 있어요. 모델 최적화 기법인 지식 증류(knowledge distillation), 가지치기(pruning), 양자화(quantization) 등을 적용해 작은 모델로도 좋은 성능을 내는 방법도 있고요. 사전 학습된 모델을 활용해 미세 조정(fine-tuning)만 수행하면 학습 비용을 크게 줄일 수 있어요. 제가 스타트업에서 일할 때는 야간이나 주말에만 GPU 인스턴스를 예약해서 비용을 절감했어요(스팟 인스턴스가 훨씬 저렴해요). 연구실이나 소규모 팀에서는 GPU 서버를 공유해 사용률을 높이고, 효율적인 학습 스케줄링 도구(예: Slurm)를 활용하는 것도 좋은 방법이에요. 마지막으로, 최신 AI 최적화 기법인 LoRA 같은 방법을 사용하면 적은 리소스로도 좋은 결과를 얻을 수 있답니다.

마무리: 기술의 발전과 미래

지금까지 AI 학습 속도를 결정짓는 칩의 역할과 다양한 측면을 살펴봤어요. 이제 한 가지 확실해진 건, AI의 미래는 단순히 알고리즘이나 데이터의 발전뿐 아니라 하드웨어의 혁신에도 크게 의존한다는 점이에요. 처음에 이야기했듯이, 학습 시간이 몇 주에서 몇 시간으로 단축된다는 건 단순한 편의성을 넘어 AI 연구와 개발의 패러다임을 완전히 바꾸는 일이죠.

특히 흥미로운 점은 AI 칩 기술이 기존의 무어의 법칙을 넘어서는 혁신을 이끌고 있다는 거에요. 범용 프로세서의 성능 향상이 둔화되는 상황에서, AI에 특화된 아키텍처는 여전히 놀라운 속도로 발전하고 있습니다. 광학 컴퓨팅, 인 메모리 컴퓨팅, 뉴로모픽 컴퓨팅 같은 획기적인 접근법들이 상용화되면 또 어떤 놀라운 발전이 있을지 기대가 되네요.

솔직히 말하자면, 저도 이 분야가 너무 빠르게 변하다 보니 항상 최신 정보를 따라가는 게 쉽지만은 않아요. 그래도 이런 하드웨어의 발전이 결국 우리가 AI로 할 수 있는 일의 범위를 넓혀준다는 점에서 정말 흥미진진한 여정이라고 생각해요. 여러분도 AI 개발을 한다면, 단순히 소프트웨어적인 측면뿐만 아니라 하드웨어의 특성과 발전 방향에도 관심을 기울여 보시는 걸 추천해요. 그럼 다음에 또 다른 흥미로운 AI 주제로 찾아뵐게요!

'Learn > 과학공학기술' 카테고리의 다른 글

| 미래형 주택, 제로에너지 하우스 A부터 Z까지 파헤치기 (5) | 2025.05.15 |

|---|---|

| 스마트폰의 두뇌 혁명: AI 칩이 바꾸는 모바일 세상 (4) | 2025.05.14 |

| AI 반도체란? CPU, GPU, TPU 차이 쉽게 이해하기 (5) | 2025.05.12 |

| 메타버스 기술의 핵심, 3D 엔진과 센서 이야기 (2) | 2025.05.11 |

| 메타버스란? 정의, 기술, 활용까지 쉽게 이해하기 (4) | 2025.05.10 |